Die Bedeutung von „sauberer“ Programmierung für SEO

Dez 20, 2016

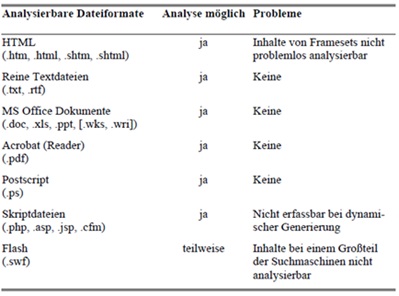

Suchmaschinen werten Dokumente im Internet aufgrund der Systematik von Information Retrieval-Systemen aus, die vereinfacht ausgedrückt die Relevanz der gefundenen Inhalte bewerten. Wegen technischer Restriktionen von IR-Systemen können diese nicht jedes beliebige Dateiformat analysieren. Aus diesem Grund muss die Analysierbarkeit der Dateiformate berücksichtigt werden.[1] Tabelle 1 zeigt eine Übersicht von durch Suchmaschinen analysierbaren Dateitypen:

Tab. 1: Übersicht von analysierbaren Dateiformaten und mögliche Probleme

Quelle: Bischopinck & Ceyp, 2009, S. 191

Erwähnenswert ist, dass sich die Indexierung von Flash-Animationen in den letzten Jahren stark verbessert hat. „Erst 2008 stellte Adobe den Suchbetreibern Yahoo! und Google die Technik bereit, um bislang nicht erschließbare Flash-Dateien verarbeiten zu können.“[2] Im Dezember 2010 gab Google in einem Statement bekannt, dass mittlerweile große Fortschritte bei der Indexierung von Flash-Inhalten erfolgt seien und man auch in Zukunft weiter daran arbeiten werde.[3]

Entgegen der allgemeinen Auffassung, muss der verwendete HTML-Code nicht zwingend W3C-konform sein (W3C ist ein Konsortium für die Festlegung von Standards im Web). Tests haben sogar gezeigt, dass nicht konforme Websites oftmals besser bei den Suchmaschinen ranken als konforme. Dies kann unter Umständen daran liegen, dass diese Internetseiten vom Code her nicht so aufgebläht sind.[4] „Guter, sauberer Code kann […] dazu führen, dass sich die Robots der Suchmaschinen auf Ihrer Seite wohlfühlen, die Seite also problemlos indexieren können und anschließend hoffentlich bald wiederkommen.“[5]

Aufgrund seiner hohen Verbreitung wird der Fokus der nachfolgenden Optimierungs-Techniken auf dem HTML-Dateiformat liegen.

Architektur

Die Architektur von Internetseiten spielt in den Augen Googles eine große Rolle. Besonders Keyword-Domains sind eine wichtige Variable, um für einen Suchbegriff gut gerankt zu werden. Diese Domains korrelieren laut der Searchmetrics-Untersuchung stärker mit positiven Rankings, also solche, die von einer beliebigen Website ohne Keyword in der URL gehalten werden. Zudem ist die Korrelation zwischen positiven Rankings und Keyword-Domains wesentlich höher als die für Keywords im restlichen URL-Teil.[6]

Abb. 1: Spearman-Korrelation Keyworddomains

Quelle: Searchmetrics GmbH, 2012, S. 23

Bei einer genaueren Betrachtung zwischen dem Keyword in der URL und einem Keyword in der Domain wird ersichtlich, dass Keyword-Domains die Top 4-5 Suchergebnisse dominieren. „Grund hierfür könnte die Schwierigkeit der Optimierung sein: Der hohe Wert von Keyworddomains ist aus SEO-Sicht vermutlich gerechtfertigt, weil sich durch bloße URLOptimierung auf bestehenden Seiten keine ähnlichen Effekte erzielen lassen. Anders gesagt: Wer seine gesamte Seite auf eine Keyword-Domain setzt, der scheint es auch für Google mit diesem Keyword ernst zu meinen. Das schnelle Anpassen der URL über eine Rewriting-Regel scheint dagegen nicht mit deutlichen Verbesserungen honoriert zu werden.“[7]

Ein weiterer wichtiger Faktor bezüglich der URL ist deren Alter. Je länger eine Domain bereits besteht, desto höher ist ihr Ansehen bei den Suchmaschinen. Dies dürfte wohl daher kommen, dass vor allem Spammer ständig neue Domains registrieren sobald ihre bisherigen von den Suchmaschinen als Spamdomains klassifiziert und aus dem Index verbannt wurden. Zu dieser Entwicklung äußerte sich der Google-Ingenieur Rand Fishkin: „regardless of their merit, or lack thereof, in a sort of “probationary category” for six months to a year to allow time to determine how users react to a new site, who links to it, etc.”[8] Google beobachtet also neu registrierte Domains, die ersten 6 bis 12 Monate, sehr genau und belegt sie darüber hinaus auch mit diversen Filtern.[9]

Im September 2003 beschrieb Google in seinem US-Patent 60/507,617 wie „gute“ von schlechten Domains maschinell differenziert werden können. Einer der Indikatoren ist dabei die Dauer, für die eine Domain bereits im Voraus bezahlt wurde, denn als Domain Registrar kann Google solche Daten einsehen. Der Hintergrund bei dieser Überlegung ist der, dass Unternehmen ihre Domains oftmals mehrere Jahre im Voraus bezahlen, um dadurch von Rabatten zu profitieren. Spammer registrieren Ihre Domains allerdings nur für ein Jahr, da sie davon ausgehen müssen, dass die Domain nach dieser Zeit sowieso aus dem Index der Suchmaschinen ausgeschlossen wird.[10]

Quellen: [1] Vgl.: Bischopinck/Ceyp, 2009, S. 190f; [2] Erlhofer, 2008, S. 241; [3] http://googlewebmastercentral-de.blogspot.de; [4] Vgl.: Fischer, 2009, S. 327; Chung/Klünder, 2007, S. 89f; [5] Winkler, 2008, S. 221; [6] Vgl.: Searchmetrics GmbH, 2012, S. 23; [7] Searchmetrics GmbH, 2012, S. 24; [8] http://articleadvocates.com; [9] Vgl.: Fischer, 2009, S. 363; [10] Vgl.: Fischer, 2009, S. 365

Wichtige Information: Die in diesem Artikel veröffentlichten Angaben sind Auszüge aus meiner am 15. Juli 2013 vorgelegten Master Thesis zum Thema: „Experiment zur Untersuchung des Zusammenspiels zwischen White-Hat- und Black-Hat-Methoden bei der Suchmaschinenoptimierung„. In einem sich extrem schnell wandelnden Bereich wie dem Online Marketing könnten einige der gemachten Angaben mittlerweile „outdated“ sein!

Mark Etting studierte Dialogmarketing und Kommunikationsmanagement, arbeitete als SEO Consultant in verschiedenen Online Marketing Agenturen und als Inhouse SEO. Seit 2015 arbeitet er als SEO Freelancer für nationale und internationale Kunden.

Telefon:

E-Mail:

kontakt*at*mark-etting.de